当搜索引擎巨头谷歌想要成为云计算的时候,几年后谷歌意识到客户还没有准备好购买掩盖底层硬件的全套平台服务,而是想要更低级别的基础设施服务,以便有更多的可选性和更多的责任,谷歌云不可避免地要从英特尔、AMD 和 Nvidia 购买计算引擎来充实其服务器群。

而且英特尔过去在 CPU 领域占据的利润率,以及 AMD 现在在 GPU 领域占据的利润率,以及在可预见的未来英伟达仍然在 GPU 领域占据的利润率,也意味着谷歌不可避免地会创建自己的 CPU 和 AI 加速器,以试图降低其服务器群的 TCO,特别是对于搜索引擎索引、广告投放、视频投放和各种形式和超大规模的数据分析等内部工作。

因此,每当 Google Cloud 活动举行时,我们都会获得更多关于 Google 在组装服务器群时购买或构建的计算引擎的信息。Google 不会像普通芯片供应商那样发布产品,不会发布大量芯片和封装图片,也不会发布大量进料、速度、插槽和功率。我们必须随着时间的推移将其拼凑起来,等待几年后发表的回顾性论文,才能知道 Google 现在到底在做什么。

这确实有点烦人。但谷歌一直都很保密,因为 IT 绝对是该公司的竞争优势,但它也有点两极分化,因为它想吹嘘自己的独创性,因为这是吸引公司下一轮创新者的原因。所有的超大规模企业和大型云建设者都是这样的。如果你有如此坚定的竞争对手,而且为了保护和发展你的业务而付出了如此多的代价,你也会这样。

话虽如此,让我们来了解一下谷歌在其主题演讲中透露的有关其计算引擎的内容,首先从“Trillium”TPU v6 自主研发的 AI 加速器开始。

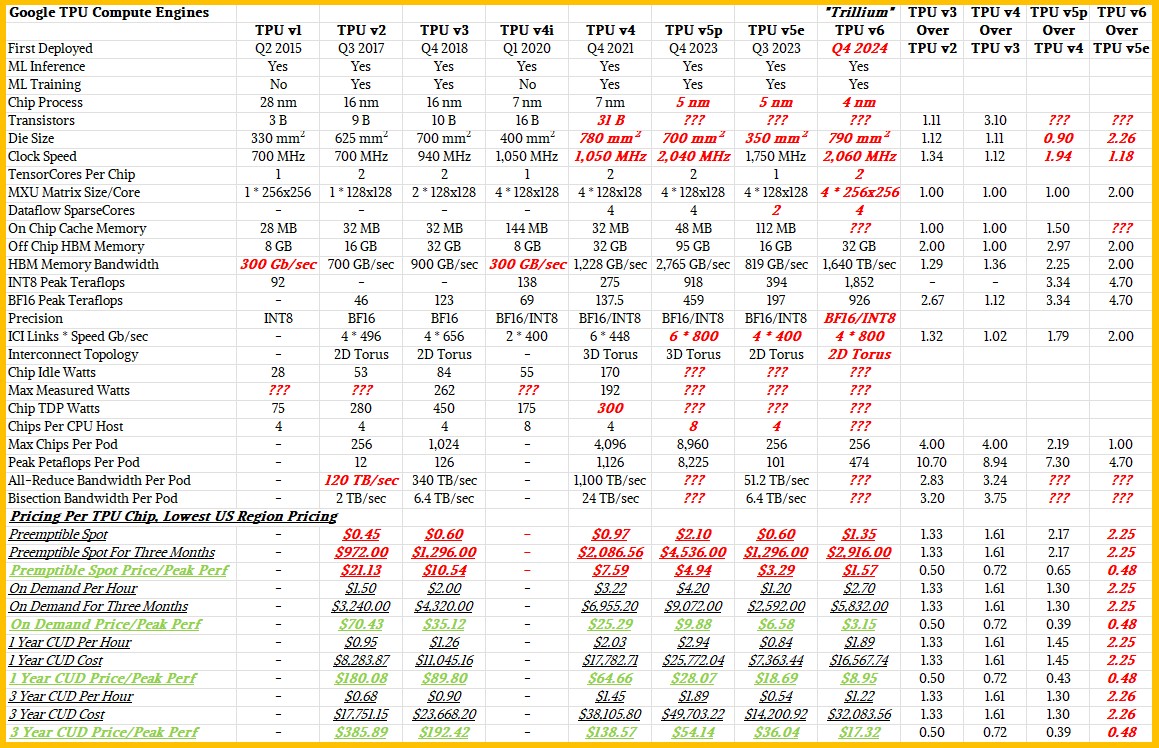

早在 6 月份,我们就对 Trillium 加速器进行了分析,这似乎是很久以前的事了,它提供了我们能找到的有关谷歌第六代自主研发 AI 加速器的详细信息。正如我们当时指出的那样,关于 TPU v6 设备及其使用系统的疑问比答案多得多。但现在,我们有了一些推理和训练的相对性能数据,以及 TPU v5e 和 TPU v6 计算引擎之间的相对性价比。

曾在 Google 负责网络工作、现任机器学习、系统和云 AI 总经理的 Amin Vahdat 在 Google Cloud App Dev & Infrastructure Summit 的主题演讲中重申了 Trillium TPU 的一些关键方面。TPUv6 的峰值性能比其在产品线中(某种程度上)取代的 TPU v5e 高出 4.7 倍,HBM 内存容量和带宽是其两倍,系统中相邻 TPU 之间的芯片间互连 (ICI) 带宽是其两倍。

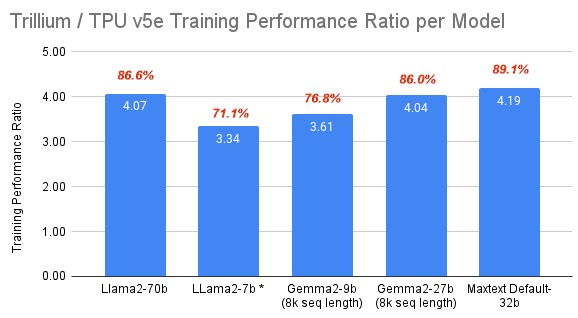

Google 还提供了用于训练和推理的一些实际基准,这些基准很有用。以下是 TPU v5e 和 TPU v6 之间的训练比较:

在这五个不同的训练基准测试中,当前 TPU 与倒数第二个 TPU 之间的平均性能提升为 3.85 倍,Google 在其演示文稿中将其四舍五入为 4 倍。我们添加了每个基准测试在基准测试中获得的峰值性能份额,相对于芯片固有的 4.7 倍。

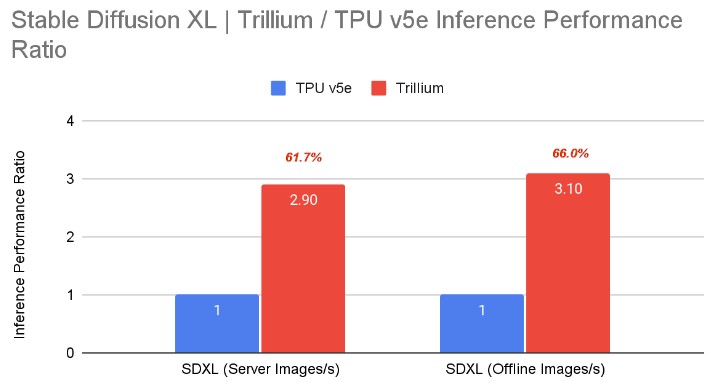

对于推理,谷歌仅展示了 Trillium 与 TPU v5e 在 Stability AI 的 Stable Diffusion XL 文本转图像模型上的性能,该模型于 7 月底刚刚发布,是最先进的:

该代码的新颖性可能是为什么 TPU v5e 和 TPU v6 之间的性能差异不到峰值性能 4.7 倍差异的三分之二的原因。

如果能看到一些不同的推理基准测试就更好了。例如,谷歌自己的 JetStream 推理引擎的基准测试结果在哪里?此外,TPU v5p 与 Trillium 芯片的比较测试在哪里?

在其描述基准测试的博客中,谷歌确实说过:“我们设计 TPU 是为了优化性价比,Trillium 也不例外,与 v5e 相比,其性价比提高了近 1.8 倍,与 v5p 相比,其性价比提高了约 2 倍。这使得 Trillium 成为我们迄今为止性价比最高的 TPU。”

我们开始尝试使用这些数据来反向计算 TPU v6 的定价,但结果却不合理。首先,谷歌在这些价格/性能比较中谈论的是训练还是推理,它使用的是真实基准还是峰值理论性能。鉴于 TPU v5p 和 TPU v5e 实例的定价不同,很难想象它们在 TPU v6 带来的价值倍数上如此接近。我们四处寻找,发现尽管 Trillium 实例仅在技术预览中,但定价已经公布。因此,我们更新了我们的 TPU 功能和定价表。请看一看:

与往常一样,红色斜体部分是我们在没有实际数据的情况下做出的估计。

需要注意的是,如果你签订的是三年合同而不是一年合同,那么基本上你可以免费获得三年中的第三年,这是一年价格的一半。这似乎相当慷慨。

从该表中可以看出,TPU v5p 的 pod 尺寸比 TPU v5e 大得多,HBM 内存带宽也高得多,在 INT8 和 BF16 浮点精度下的性能只有 TPU v6 的一半。据我们所知,TPU v6 pod 尺寸在单个图像中为 256 个加速器,在 INT8 精度下峰值为 474 petaops。Vahdat 证实了这一点,然后推断出了 pod 之外的情况。

“Trillium 可以从单个 256 芯片、高带宽、低延迟、ICI 域扩展到由每秒多 PB 的数据中心网络互连的楼宇级超级计算机中的数万个芯片,”Vahdat 解释道。“Trillium 在单个集群中提供前所未有的 91 exaflops,是我们使用上一代 TPU 构建的最大集群的四倍。客户喜欢我们的 Trillium TPU,我们看到对第六代产品的需求空前高涨。”我们不确定他指的是 BF16 精度下的“exaflops”,还是 INT8 精度下的“exaops”,并像我们在本报道中最初所做的那样说“exaflops”。

考虑到 TPU v6 实例仅处于技术预览阶段,所以给予赞扬的肯定是少数非常重要的客户。

Vahdat 还展示了一些 Trillium 设备的图片。这是一块 TPU v6 系统板,上面有四个 TPU v6 计算引擎:

这里有一些这种 Trillium 铁的架子,架子前面露出一个暗示性的节点。

现在,转向 Nvidia GPU 基础设施,Google Cloud 必须构建该基础设施,以便公司可以在云基础设施上部署 Nvidia AI Enterprise 软件堆栈,并且 Google 和 Nvidia 也在对其进行调整,以运行 Google 首选的 JAX 框架(以 Python 编写)和其 XLA 跨平台编译器,该编译器可以流畅地使用 TPU 和 GPU。

Google 已经推出了基于 Nvidia “Hopper” H100 GPU 加速器的 A3 和 A3 Mega 实例,这些加速器具有 80 GB 和 96 GB 的 HBM3 内存,而 Vahdat 则借此机会预览了即将在 Google Cloud 上推出的基于 Hopper H200 GPU 的全新 A3 Ultra 实例,该实例具有更大的 141 GB HBM3E 内存。A3 Ultra 实例将于“今年晚些时候”推出,它们将包括 Google 自己的“Titanium”卸载引擎和 Nvidia ConnectX-7 SmartNIC,后者将使用 Google 的 RoCE 以太网交换调整,以 3.2 Tb/秒的带宽将集群中的 GPU 互连起来。

Vahdat 并未对 Nvidia 已发布和即将推出的“Blackwell” GPU 透露太多信息,但表示该公司“拥有几个正常运行的 Nvidia GB200 NVL72 机架,并正在积极致力于将这项技术带给我们的客户”。

Vahdat 还补充说,基于 Google 自己的“Cypress”Axion Arm 服务器 CPU 的 C4A 实例现已普遍可用。Google早在 4 月就宣布了第一款 Axion 芯片,但显然还有两款芯片正在研发中,另一款代号为“Maple”,基于 Marvell 和 Cypress 授权的 Neoverse V2 内核技术。Axion 处理器还与 Titanium 卸载引擎配对。

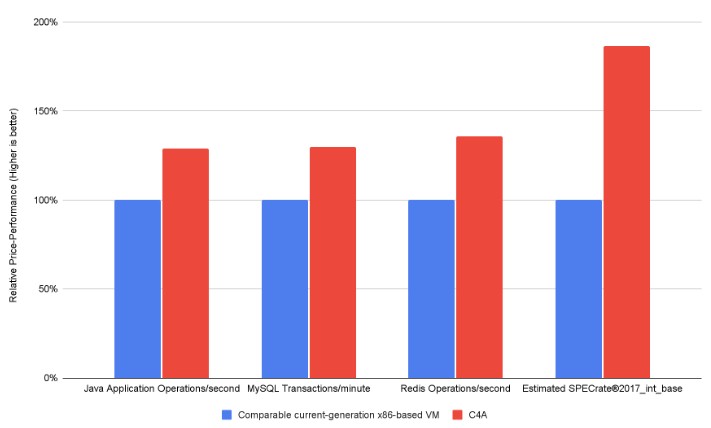

谷歌表示,C4A 实例在 SPEC 整数基准测试中的性价比比“当前一代基于 X86 的实例”高出 64%,能源效率比“当前一代基于 X86 的实例”高出 60%,但没有具体说明这些实例是什么。他补充说,C4A 实例的性能比其他云上的其他 Arm 实例高出 10%。他没有说明 Axion 处理器的性能与英特尔“Granite Rapids”Xeon 6 或 AMD“Turin”Epyc 9005 CPU 相比如何。

为了好玩,谷歌展示了这张性价比图表:

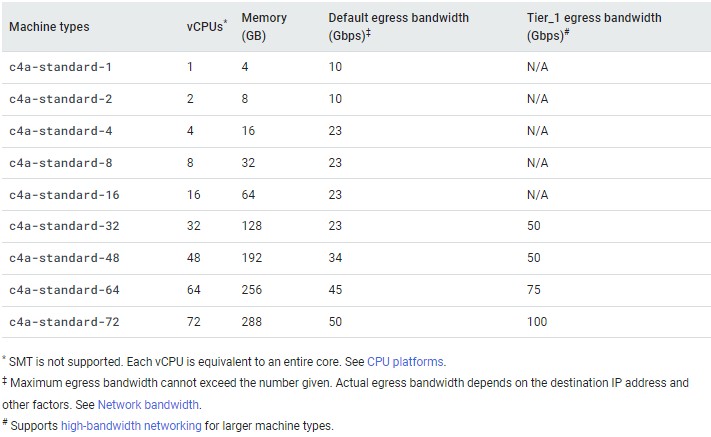

到目前为止,我们还不知道 Axion C4A 实例是什么样子,因此这里是 C4A 实例标准版的速度和馈送,每个 vCPU 有 4 GB:

Axion C4A 实例有高 CPU 配置,每个 vCPU 有 2 GB 内存,也有高内存配置,每个 vCPU 有 8 GB 内存。正如细则所述,Axion 芯片中的这些 V2 核心不支持同时多线程,因此核心就是线程,也就是 vCPU。

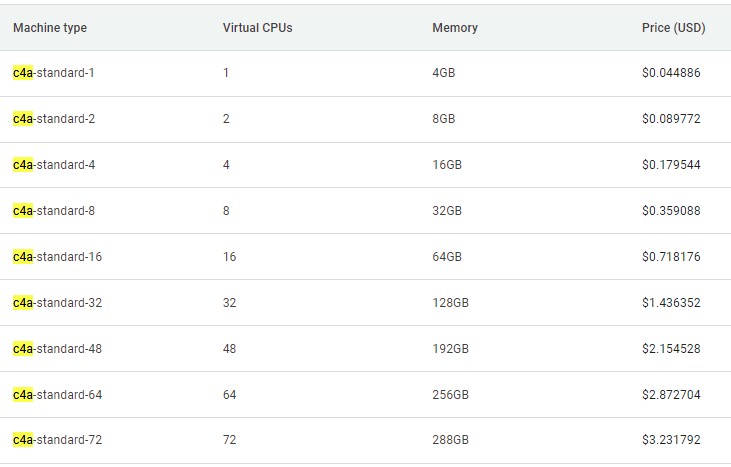

以下是 Google 北弗吉尼亚 (US-East-4) 地区标准实例的每小时定价:

C4A 实例已在美国中部 1(爱荷华州)、美国东部 4(弗吉尼亚)、美国东部 1(南卡罗来纳州)、欧盟西部 1(比利时)、欧盟西部 4(荷兰)、欧盟西部 3(法兰克福)和亚洲东南部 1(新加坡)地区推出;预计很快将在其他地区推出。

我们期待对在各个云中运行的 AWS Graviton 4、Google Cloud C4A 和 Microsoft Azure Cobalt 100 Arm 服务器芯片进行比较。